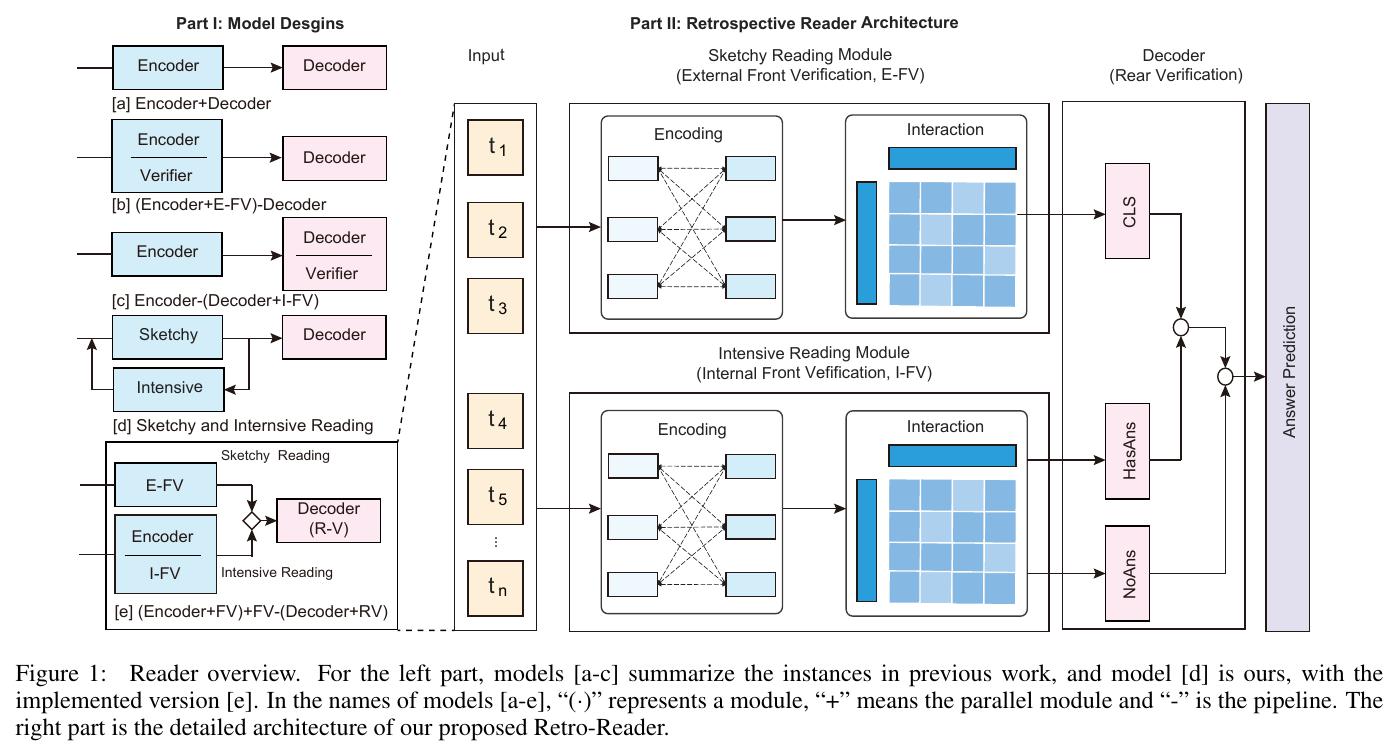

继2019年7月我系赵海教授团队在机器阅读理解的旗舰排行榜SQuAD2.0荣登单模型第一,并首次取得单模型超越人工的成绩之后,近日,再传捷报,赵海教授团队在更强的竞争对手不断刷新新高的情况下,取得了该排行榜单模型(single)和组合模型(ensemble)双第一。

这项工作最新论文预印本见:https://arxiv.org/abs/2001.09694

实用的阅读理解任务不仅需要根据给定篇章准确回答问题,还要识别并拒绝无法回答的问题。受人类的阅读理解模式的启发,我们提出了一种回顾式阅读器(Retrospective Reader)。2020年1月19日,在斯坦福大学发起的机器阅读理解挑战赛SQuAD 2.0 (Stanford Question Answering Dataset 2.0) 中,我们的回顾式阅读器基于ALBERT预训练语言模型荣登榜首,同时刷新了单模型和集成模型的最佳纪录。

对于伴随不可回答问题的机器阅读理解任务,阅读器模型需同时具备两方面能力:

1)判断问题是否可回答;

2)对于可回答问题作出准确回答。

为了对可回答性作有效判断,需要对给定的文本有更深入、更全面的理解以及相应的精巧的判别器设计。

对于阅读理解考试,人类的阅读思路通常是:首先,通读全文和问题、掌握大意,做出初始判断;其次,复读全文、验证答案,综合判断后给出最终答案。受此启发,,回顾式阅读器模型利用略读模块(sketchy reading)和精读模块(intensive reading)来模拟人类阅读。前者用于阅读文章和问题,得出初步判断;后者验证可回答性,在可以回答的情形给出答案候选。两个模块的输出汇总后,综合判断做出最终决策。

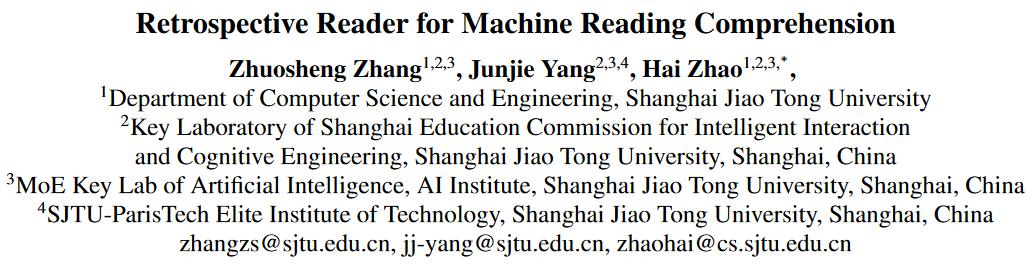

图1 回顾式阅读理解器的模型设计

如图1,回顾式阅读器有三个步骤完成:

(1) 略读模块由编码层、交互层和外部前置验证器(E-FV)构成。编码层用于将输入文本编码,进而输入到交互层构建篇章和问题间的向量关系,得到的表示用于验证器做出可回答性的初步预测。

(2) 精读模块使用与略读模块同样的编码和交互,得到隐层表示后,得到用于可回答问题的起止位置概率的同时,并行输入到内部前置判别器(I-FV),得到不可回答的概率。

(3) 内部和外部前置判别器的不可回答概率在后置判别器中(RV)综合,做出最终的回答决策。

经验性结果表明:回顾式阅读器显著优于基准模型ALBERT,帮助其在SQuAD2.0排行榜超越了所有模型,再次刷新了单模型和集成模型的最佳纪录(图2)。

图2 SQuAD2.0排行榜

下面给出了基准ALBERT预训练语言模型和回顾式阅读器模型关于SQuAD2.0示例的预测。这个例子表明回顾式阅读器在判断问题是否可回答方面更有效,能有效避免给出似是而非的“陷阱答案”。

|

篇章:

Southern California consists of a heavily developed urban environment, home to some of the largest urban areas in the state, along with vast areas that have been left undeveloped. It is the third most populated megalopolis in the United States, after the Great Lakes Megalopolis and the Northeastern megalopolis. Much of southern California is famous for its large, spread-out, suburban communities and use of auto-mobiles and highways...

|

|

问题:

What are the second and third most populated megalopolis after Southern California?

|

|

答案:

正确答案:不可回答

ALBERT(+TAV)阅读器的答案:Great Lakes Megalopolis and the Northeastern megalopolis

回顾式阅读器的答案:不可回答

|

上海交通大学自然语言处理实验室-机器阅读理解团队简介:

上海交通大学自然语言处理实验室是国内外最早开展机器阅读理解研究的团队之一,在赵海教授主持指导,近年来多次斩获国际比赛与评测第一的荣誉:

1. 2019年1月,大型考试类阅读理解任务数据集RACE排行榜第一(联合云从科技),首次超越人工评测成绩;

参考网址:http://www.qizhexie.com/data/RACE_leaderboard

2. 2020年2月,RACE排行榜冠军再次获得单模型第一名;

3. 2019年7月,国际权威机器阅读理解排行榜SQuAD2.0冠军(联合云从科技),首次以单模型超越人类基准,首次在F1指标上仅以单模型超过90%得分;

参考网址:https://rajpurkar.github.io/SQuAD-explorer/

4. 2019-2020年,斯坦福自然语言推理排行榜SNLI第一名;

参考网址:https://nlp.stanford.edu/projects/snli/

5. 2020年2月,基于对话的阅读理解DREAM排行榜第一名(联合华为诺亚方舟实验室)。

参考网址:https://dataset.org/dream/